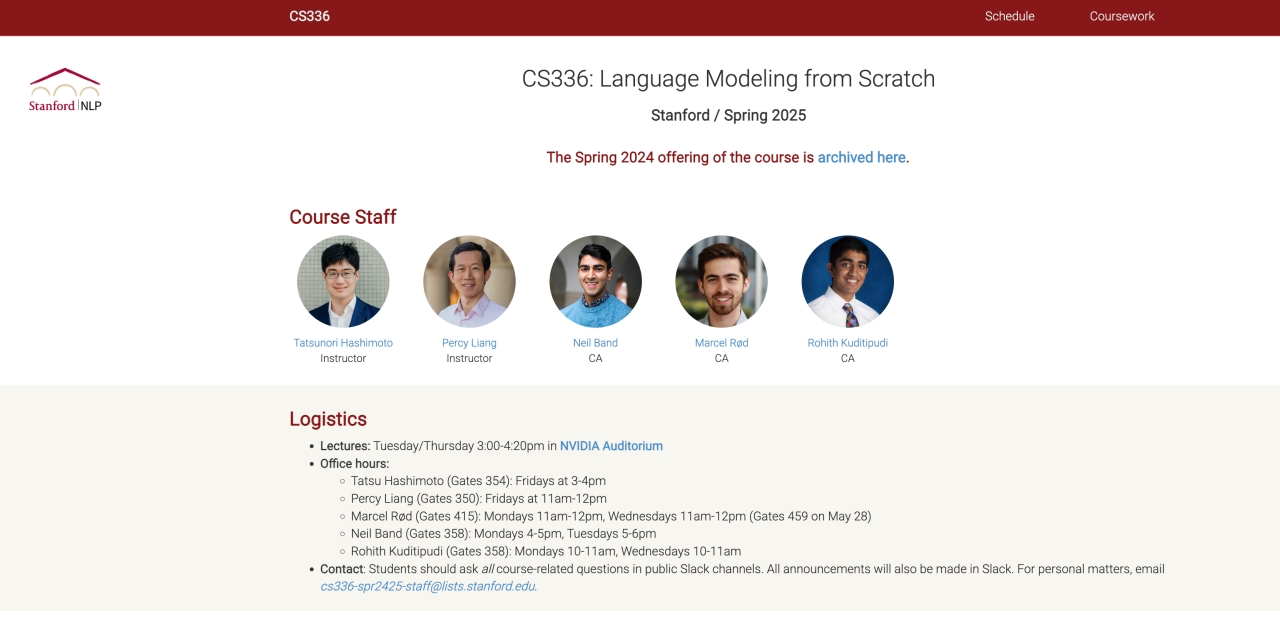

官方网站:https://cs336.stanford.edu/

去年该课程没有放出视频,今年官方放出了视频。课程内容均结合今年的大模型发展做了更新。

在这个许多人通过高级API与大语言模型交互的时代,本课程旨在让研究者和开发者重新连接到底层技术。我们坚信,要真正理解语言模型,你必须亲手构建它。

每次课程内容:

1. 4月1日 周二 概述与分词

本节课深入探讨第一个技术组成部分 :Tokenization。

中英字幕版本:斯坦福CS336第一课:Tokenization详解 - 小红书

2. 4月3日 周四 PyTorch与资源核算

这堂课主要讲解了如何从头开始构建语言模型,特别是关注 PyTorch 中的基本构件以及效率(内存和计算资源的使用)

课程目标与重点: 核心是实际构建模型,理解 PyTorch 的基本元素(张量、模型、优化器、训练循环)。 高度关注效率,包括内存占用和计算资源(FLOPs)的估算与优化。 侧重于 PyTorch 的机制 (mechanics) 和资源核算的心态 (mindset)。

中英字幕版本:斯坦福CS336第二课:pytorch手把手搭建LLM - 小红书

3. 4月8日 周二 架构与超参数

关于 LLM 架构和训练,那些你想知道的一切

1)Transformer 架构回顾与演进趋势

2)核心架构变体:归一化、激活函数与层结构

3)位置编码的收敛:RoPE 的主导

4)超参数选择的经验法则与共识

5)训练稳定性技巧:应对 Softmax 的挑战

6)注意力头部的变体:推理优化与长上下文处理

中英字幕版本:斯坦福CS336第三课:详解LLM基础架构 - 小红书

4. 4月10日 周四 混合专家模型

混合专家模型(Mixture of Experts, MoE)

去年,这只是一个有趣的额外讲座。但今年,由于很多人都在研究MoE,这节课变得更加重要。所以老师加入了很多最近的进展。最后,尝试剖析DeepSeek V3,理解构成这样一个最先进的开源系统(至少在架构方面)的各种组件。 MoE架构与非MoE架构在大部分组件上是相似的,主要区别在于如何处理前馈神经网络(FFN)层。在一个标准的Transformer模型中,FFN通常是一个单独的、密集的模块。而在MoE模型中,这个单独的FFN会被替换为多个(可能是复制或分割而来)较小的FFN副本,这些副本被称为“专家”。同时,会引入一个“路由器”(router)或“选择器”(selector)层。在每次前向传播或推理过程中,路由器会根据输入选择激活一小部分(例如,一个或几个)专家进行计算。这样做最大的好处是,如果每个专家的大小与原始密集模型的FFN相同,并且每次只激活一个专家,那么模型的总参数量可以显著增加,而计算量(flops)却保持不变。这对于那些相信更多参数能帮助模型记忆更多世界知识的观点来说,是一个极具吸引力的架构。

大量研究表明,在相同的训练计算量(training flops)下,混合专家模型能取得比密集模型更优的性能。 尽管MoE在flops效率上表现出色,但其并非没有代价。一个主要的挑战在于系统实现的复杂性。有效地路由数据到成百上千个专家,并保证计算效率,需要复杂的基础设施支持。

DeepSeek MoE的创新:共享专家与细粒度专家

中英字幕版本:斯坦福CS336第四课:详解MOE架构 - 小红书

5. 4月15日 周二 GPU技术

第五课介绍了GPU的工作原理以及如何针对其特性优化深度学习工作负载,特别是语言模型。

对比CPU和GPU的设计哲学与架构差异,并深入解析GPU的内部构造和工作模式,之后简要介绍了TPU。

接着介绍GPU性能优化技巧 (六大秘技)

之后讲性能曲线

最后用flash attention 1/2结尾。

中英字幕版本:斯坦福CS336第五课:详解GPU架构,性能优化 - 小红书

6. 4月17日 周四 内核与Triton

GPU基础知识回顾

性能测试与性能分析

编写高性能算子,Cuda C++实现,Triton实现

手把手教学:Softmax的Triton实现

中英字幕版本:斯坦福CS336第六课:手写高性能算子 - 小红书

7. 4月22日 周二 并行计算

讲座提供了一个全面的多机多卡并行训练框架。

核心思想是根据硬件特性(节点内高速互联、节点间相对慢速互联)和模型/训练需求(显存、算力、批次大小),有层次地组合使用张量并行(解决节点内显存和计算)、FSDP/流水线并行(解决跨节点显存)、数据并行(扩展整体吞吐)以及序列并行(进一步优化激活显存)。

理解各种并行策略的优缺点、通信模式和成本,并巧妙利用集合通信的等价关系(如All-reduce分解),是实现高效大规模分布式训练的关键。

中英字幕版本:斯坦福CS336第七课:详解多机并行化策略 - 小红书

- 4月24日 周四 并行计算

讲座核心围绕着如何在多GPU环境下实现模型训练的并行化,以最大限度地利用硬件资源,加速模型训练。 重点在于理解和减少数据传输瓶颈,因为数据传输通常比计算慢得多,是性能的主要制约因素。

中英字幕版本:斯坦福CS336第八课:手撕大模型并行训练

- 4月29日 周二 缩放定律

讲座指出,传统的深度学习方法是训练大量大型模型并调整其超参数,这会耗费巨量计算资源。 而缩放定律的核心思想和新范式是:通过训练一系列小型模型,学习它们的行为规律,然后将这些规律外推到大型模型上,从而在第一次尝试构建大型模型时就能“一击即中”,实现高效的工程优化。 这提供了一种在资源有限的情况下,通过系统性实验和预测来指导大模型研发的清晰路径,避免了盲目试错。

中英字幕版本:斯坦福CS336第九课:详解Scaling Law

5月1日 周四 推理技术

5月6日 周二 缩放定律

5月8日 周四 模型评估

5月13日 周二 数据相关技术

5月15日 周四 数据相关技术

5月20日 周二 对齐技术 - SFT/RLHF

5月22日 周四 对齐技术 - 强化学习

5月27日 周二 对齐技术 - 强化学习

5月29日 周四 Junyang Lin嘉宾讲座

6月3日 周二 Mike Lewis嘉宾讲座